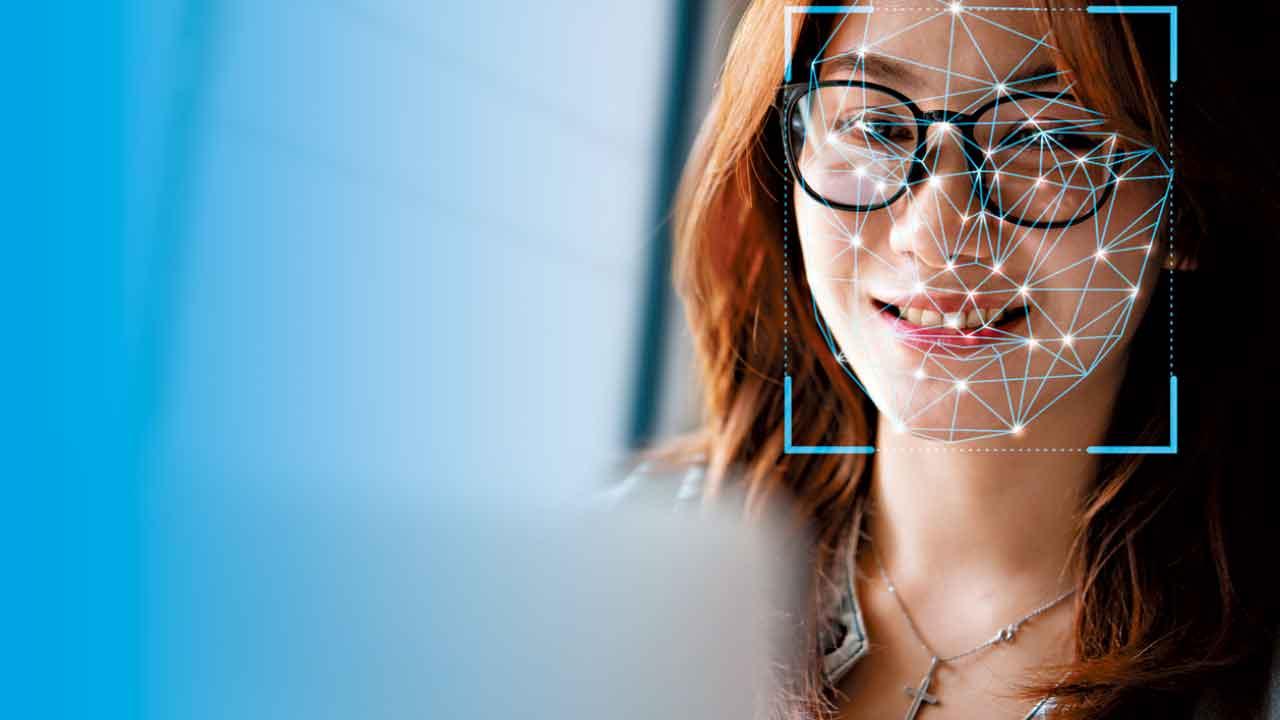

AI普及,要修改影音相片已不是高難度技術。 (資料圖片)

人工智能迅速發展,被不法分子利用作非法活動,亦有人因「貪得意」將他人相片移花接木製成裸照。關注婦女性暴力協會指,近年接獲涉及合成私密影像的求助持續上升,上年度錄得11宗。協會表示,雖然有意見認為「深偽」影像中的性暴力內容並非真實,因而無傷大雅,但事實上,這類影像對受害人造成的傷害是持續且深遠的。有受害人更指,事發已數年,現時仍活在恐懼中。

數年前曾經歷「深偽」影像性暴力的受害人Janice表示,事件令她長期活在恐慌。她指,「就算(合成相)唔係真,都好難同全世界解釋(唔係真相)」,即時解釋亦不是所有人均相信自己。「(外出時)會幾擔心被人認出、被跟蹤、被人笑」。因為擔心唯有不外出,「每日深夜都會偷偷地喊。一直封閉自己,會關閉自己所有社交帳號、唔想再見朋友,又有試過曠工……每日都好怕身邊嘅人收到假相,好怕其他人對自己有偏見。」現時偷他人相片再合成已變得輕而易舉,令她很擔心同類事件會再發生。

關注婦女性暴力協會總幹事莊子慧認為,應提高公眾的數碼素養,同時涵蓋相關平台及人工智能工具使用的討論。促進負責任的科技使用,方可有效緩減網絡空間的性別不公,減少發生科技促致的性暴力。當局更須積極投入資源促進尊重、積極同意和界線的教育,同時透過不同層面工作保障市民免受「深偽」技術合成個人特徵(包括臉容、身體和聲音)所帶來的侵害。

另外,港大一名法律系學生疑透過人工智能軟件,以多名同學、朋友及老師的照片生成大量色情照片。港大就事件再發聲明指,已向相關男學生發警告信,男學生亦向受影響的同學正式道歉,並已主動退出下學年為期一年的海外學術交流。港大澄清,大學自收到投訴後一直跟進事件,亦會配合執法機構,並繼續審視事件細節,必要時採取進一步行動。平機會主席林美秀表示,注意到媒體報道相關事件,平機會亦收到投訴,由於個案正在處理,不宜在此階段回應。